Teknik för specialeffekter har sett en verklig boom under de senaste decennierna, med CGI som gått från rudimentärt rå och primitiv till nästan oskiljbar från verkligheten. Nu, när skapandet av verisimilitudinösa bilder blir allt vanligare, så förväntar sig politiska kunniga och straffrättsexperter en panik kring så kallad 'deep fake' -teknologi, som har potential att ytterligare komplicera en pågående internationell diskussion om 'fake news'. Men vad är exakt en 'djup falsk' och hur mycket av ett hot kommer denna teknik att utgöra i framtiden?

Djup falsk (ibland stiliserad som 'deepfake') -teknologi hänvisar till syntetiserade och / eller överlagrade bilder och / eller videor skapade av artificiell intelligens med befintliga bilder och videor. Med hjälp av maskininlärning kan denna teknik teoretiskt skapa övertygande bilder av en person som utför en handling som faktiskt aldrig inträffade i verkliga livet.

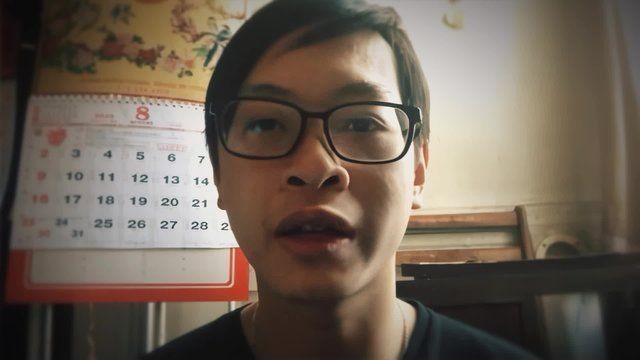

Owen Williams, en professionell programvarutekniker och konstnär för visuella effekter, erbjöd en enkel förklaring.

'Det är ett sätt att använda ett automatiserat mjukvarusystem för att ersätta en persons ansikte i en video med ett annat ansikte som är mycket mer automatiskt och övertygande än vad som varit möjligt med tidigare teknik,' sa Williams. Oxygen.com .

Williams noterade att vanliga, populära filmer som 'Jurassic Park' och 'Blade Runner: The Final Cut' använde datorprogramvara för vissa scener på sätt som kan ha varit en föregångare till djupa förfalskningar: 'I filmindustrin är detta riktigt vanligt. Låt oss säga att du har en karaktär som behöver utföra ett stunt och du föredrar att deras ansikte är synligt. Den klassiska lösningen skulle vara att du bara skulle se dem bakifrån, eller att deras hår skulle vara i ansiktet så att du inte kunde säga att det var en dubbel. Men det finns en ganska inblandad historia av filmskapare som använder datorer för att sätta en skådespelares ansikte över en stunt-dubbel. '

'Det brukade vara en mycket manuell process', fortsatte Williams. Nu med djup falsk teknik matar du en dator två saker: Först videon du ska ersätta och sedan en massa ingångar i ansiktet du ska ersätta med. Du måste få tillräckligt med bilder av en person som gör olika ansiktsuttryck och från olika vinklar. Du skapar ett bibliotek med hur den här personens ansikte kan se ut i olika situationer, och sedan går datorn igenom och tittar på videon. Det behöver inte heller någon exakt matchning. Det kan klämma och förvandla vad det har i biblioteket för att passa det det behöver. Det som tidigare krävde dussintals konstnärer hundratals timmar för att försöka utföra en riktigt komplicerad effekt nu är bara ett knapptryck. '

En aspekt av denna teknik som oroar människor är att en person inte nödvändigtvis villigt skicka sitt ansikte för att denna process ska kunna genomföras, med tanke på hur många bilder som finns online av de flesta - särskilt kändisar och politiska personer.

'Det finns tillräckligt med bilder av någon kändis i tillräckligt många vinklar för att du kan skapa det biblioteket [utan samtycke],' sa Williams. 'Det krävs en viss mängd arbete för att göra det, men för alla marginellt populära figurer kommer saker att existera. Min känsla är att det är mindre troligt att detta skulle vara så möjligt för en vanlig person. ''

De första djupa falska videorna dök upp på Reddit-forum i slutet av 2017, enligt Variety . En användare hävdade att han använde sin dator för att skapa mycket realistiska pornografiska videor av olika kändisar som ägde sig åt sexuella aktiviteter som faktiskt aldrig hände i verkligheten. Användaren hävdade att han matade sin dator tusentals foton av stjärnorna, från vilka AI kunde få ansiktsuttryck och rörelser som visas. En app som används av djupa falska skapare och delas på Reddit laddades så småningom över 100 000 gånger. (Reddit skulle så småningom fortsätta att förbjuda denna typ av innehåll och säga att det stred mot deras politik för '' ofrivillig pornografi '' enligt The Verge .)

Den realism som detta medium kan uppnå just nu tvivlar Williams.

'Om du någonsin sett någon av dessa djupa förfalskningar ... finns det en viss konstighet där', sa Williams. 'De är inte polerade. Det kommer troligen att bli bättre och bättre, särskilt för att Hollywood har ett intresse av att göra detta automatiserat snarare än att betala dyra artister. '

På samma sätt gissade Williams det trots paniken kring djup falsk porr , de förändrade kulturella attityderna kring karaktären av saker som hämndporr eller läckta nakenbilder innebär att det är troligt att människor som skapar denna typ av media skulle fördömas och inte firas, inte ens inom vuxenunderhållningsindustrin.

'Det kommer aldrig att bli vanligt', teoretiserade Williams. 'Efter ' The Fappening 'Det hände på Reddit, folk kunde ändra konversationen och säga,' Det här är inte en skandal, det är ett sexbrott. ' Så jag ser bara inte att detta blir så mycket av en skandal som folk tror att det kommer att göra. Människor kan också ganska enkelt hitta den ursprungliga porr som den djupa falska skapades från, vilket betyder att det är ganska lätt att debunkera. '

Men det orsakar inte bara oro eftersom det kan användas för att skapa falsk kändisporr. Människor är också oroliga för de politiska konsekvenserna.

Politiska kunniga började skriva om spridningen av djupa förfalskningar 2018. En Guardian-artikel från november samma år noterade den virala spridningen av en video som förmodligen skildrar president Donald Trump som uppmuntrar Belgien att dra sig ur Paris klimatavtal. Detta katalyserade en större diskussion om potentialen för olika regeringar att använda denna teknik i massdisinformationskampanjer, en konversation som redan hade inletts tack vare den pågående utredningen av Rysslands engagemang i USA: s presidentval 2016.

Paniken kring djupa förfalskningar inspirerade till och med redaktionen för Bloomberg Media Group att skriva ett starkt formulerat yttrande i frågan.

”Videobevis har blivit en pelare i det straffrättsliga systemet ... just för att filmen verkar vara en så tillförlitlig registrering av någons tal eller handlingar. Djupa förfalskningar kan möjligen göra sådana bevis misstänkta, ' de skrev i juni 2018. 'En övergripande utmaning kommer då att vara att identifiera och utrota dessa förfalskningar - om det är möjligt.'

Williams instämde i att naturen av djupa förfalskningar hotar våra uppfattningar om '' verklighet '' med avseende på videobevis, men noterade att denna lagliga gös inte är unik för vårt samtida digitala landskap.

'Det kommer på det sättet att denna idé är att människor har den videon lika med sanningen, vilket aldrig har varit fallet. Vi visste detta från och med Rodney King. Eller tänk på Eric Garner : Folk tyckte att [tjänstemannen som dödade honom] var oskyldig oavsett vilken video av händelsen förutspådde. För mig [en hel del av rädslan kring djupa förfalskningar] verkar det något ogrundat. '

Williams listade flera andra incidenter som inte involverade djup falsk teknik som visade hur videon djärvt har manipulerats för att vrida allmänhetens åsikt i en fråga, som James O'Keefes kontroversiella borttagning av ACORN och en ny skandal med doktrerad video som förmodligen visar CNN-reporter Jim Acosta som attackerar en anställd i Vita huset .

Williams ultimata slutsats var att hysterin kring djupa förfalskningar är något överblåst.

”Det jag ser hända är att det kommer att fungera åt båda hållen. Om en video kommer ut och den är riktig kommer folk att hävda att den är falsk. Om en video kommer ut och den är falsk, kommer folk att hävda att den är riktig. Varje fall antar en viss mängd sanning som tilldelats videon [sig själv]. Det är svårt att veta vilken riktning allt detta kommer att gå in. Om Pissbandet faktiskt kom ut, till exempel, du vet exakt vad som skulle hända: Halva folket skulle säga, 'Detta är tjurar - t, det är någon skådespelare!' och hälften av folket skulle säga: 'Det är det! Det är verkligt!' Så ingenting skulle verkligen förändras. Det brukar vara det som händer med ny teknik: Saker förändras inte så mycket som folk tror.

[Foto: SAUL LOEB / AFP / Getty Images]